Toda la historia de la SB 1047 es larga y complicada, pero la esencia es bastante simple. En general, la industria de la inteligencia artificial no quiere ser regulada. Especialmente no quiere ser responsable de los daños causados por sus modelos de IA. Dado que la SB 1047 regula la industria y utiliza la responsabilidad para hacer cumplir esas regulaciones, gran parte de la industria no quiere el proyecto de ley.

Los expertos de la industria no pueden decir esto explícitamente, por lo que en su lugar presentan otros argumentos (a menudo en contra de versiones del proyecto de ley que no existen). No es muy sorprendente que estos argumentos realmente no resistan el escrutinio.

La SB 1047 ordenó principalmente que los mayores desarrolladores de IA implementaran salvaguardas para mitigar los riesgos catastróficos. Si el modelo de IA de una empresa cubierta causa un desastre, definido como “víctimas masivas” o daños por valor de 500 millones de dólares o más y las salvaguardias de la empresa no estaban en línea con las mejores prácticas de la industria y/o los estándares gubernamentales pertinentes, entonces la empresa podría ser responsable de daños y sanciones económicas adicionales. El proyecto de ley también incluía protecciones para los denunciantes de IA.

Habría sido la primera ley en Estados Unidos que obligaría a estas empresas a implementar salvaguardias para mitigar riesgos catastróficos, rompiendo con la tradición de utilizar los compromisos voluntarios de seguridad de la IA preferidos por la industria y los legisladores nacionales.

Al oponerse al proyecto de ley del Senado de California, OpenAI, Meta, Microsoft y Google argumentaron que las regulaciones de IA deberían realizarse a nivel federal.

Sin embargo, los republicanos se han comprometido a obstruir una importante legislación nacional y deshacer la orden ejecutiva de Joe Biden sobre la IA, lo más parecido a una regulación nacional sobre la IA. Estas empresas también tienen mucho menos que temer de los legisladores federales, que están en mayor medida en su bolsillo. En agosto, ocho representantes demócratas de California publicaron una carta contra el proyecto de ley que estaba llena de temas de conversación de la industria.

La ex presidenta de la Cámara de Representantes, Nancy Pelosi, siguió poco después de la carta del Congreso con su propia declaración contra el proyecto de ley, en lo que parece ser la primera vez que se opone a una legislación a nivel estatal de un miembro de su propio partido.

La declaración financiera de Pelosi de 2023 informa que su marido posee entre 16 y 80 millones de dólares en acciones y opciones de Google, Amazon, Microsoft y Nvidia. Y se espera que Christine, la hija de Pelosi, se presente contra el autor del proyecto de ley, el senador estatal Scott Wiener, por el puesto de ex presidenta del Congreso tras su jubilación. Esta creencia ha provocado especulaciones de que está tratando de dañar a Wiener y elevar a Christine.

El extraño patrón de respaldo de Pelosi en San Francisco también tiene más sentido cuando te das cuenta de que todos han peleado con Wiener. Es evidente que Pelosi no ha respaldado a Wiener en su campaña de reelección.

Como comenté anteriormente en el Nación, Los opositores de la SB 1047 afirman que hay una “protesta pública masiva” contra el proyecto de ley y resaltan los daños imaginarios y sin fundamento que sufrirán víctimas comprensivas como académicos y desarrolladores de código abierto. Sin embargo, el proyecto de ley apunta directamente a los desarrolladores de inteligencia artificial más grandes del mundo y cuenta con un apoyo popular en todo el estado, con un apoyo aún más fuerte de los trabajadores tecnológicos.

Esta dinámica fundamental se mantuvo prácticamente igual, pero en última instancia resultó en algunos extraños compañeros de cama: el multimillonario Elon Musk se alía con grupos de justicia social y sindicatos para apoyar el proyecto de ley, mientras que la ex presidenta de la Cámara de Representantes, Nancy Pelosi, el congresista progresista de la Cámara de Representantes, Ro Khanna, la empresa que apoya a Trump el capitalista Marc Andreessen y la “madrina” de la IA, Fei-Fei Li, se oponen.

Sin embargo, desde la carta del Congreso y la declaración de oposición de Pelosi en agosto, el impulso recayó casi exclusivamente en los partidarios del proyecto de ley.

Anthropic se diferenció de otras empresas líderes en inteligencia artificial al escribir en una carta abierta que los “beneficios probablemente superen los costos” del proyecto de ley revisado. Su carta siguió a una ronda de enmiendas realizadas directamente en respuesta a las preocupaciones anteriores de la empresa.

La SB 1047 fue aprobada por ambas cámaras de la legislatura de California con amplias mayorías y siguió obteniendo buenos resultados en las encuestas. Todas estas encuestas fueron realizadas por una organización sin fines de lucro pro-regulación, pero el resultado principal no cambió cuando el centro de encuestas permitió que un oponente escribiera los argumentos contrarios.

Más de 110 empleados actuales y anteriores de las cinco principales empresas de IA (todas ellas con sede en California) publicaron una carta a favor del proyecto de ley, argumentando que “los modelos de IA más potentes pronto podrían plantear riesgos graves, como un mayor acceso a los recursos biológicos”. armas y ciberataques a infraestructuras críticas”.

Las cartas instando a la firma de Newsom fueron firmadas por SAG-AFTRA y estrellas de Hollywood como Ava DuVernay, Jane Fonda, JJ Abrams, Shonda Rhimes, Alec Baldwin, Pedro Pascal, Jessica Chastain, Adam McKay y Ron Perlman.

Los respaldos finales llegaron de grupos poderosos como ParentsTogether y la rama de California de la AFL-CIO, uniéndose al apoyo anterior de grupos como SEIU, la Fundación Comunitaria Latina y la Organización Nacional de Mujeres.

En última instancia, esta coalición expansiva no fue suficiente para superar la amarga oposición de la industria tecnológica y de poderosos demócratas nacionales como Pelosi.

OpenAI, Meta y Google argumentaron que el proyecto de ley podría asustar a las empresas de IA para que abandonen California. Sin embargo, la SB 1047 se habría aplicado a cualquier empresa de IA cubierta que hiciera negocios en el estado, que es la quinta economía más grande del mundo y hogar de las cinco principales empresas de IA generativa. El director ejecutivo de Anthropic, Dario Amodei, descartó esta noción como “simple teatro”.

Los aliados más poderosos de la industria fueron los demócratas nacionales que se manifestaron en contra del proyecto de ley. Pero contaron con una gran ayuda de la “madrina de la IA” y profesora de Stanford, Fei-Fei Li, quien publicó un artículo de opinión en Fortuna afirmar falsamente que el “interruptor de apagado” de la SB 1047 destruiría efectivamente la comunidad de IA de código abierto. El artículo de opinión de Li fue citado de manera destacada en la carta del Congreso y en la declaración de Pelosi, donde el ex presidente dijo que Li es “considerado el principal académico e investigador de IA de California y uno de los principales pensadores de IA a nivel mundial”.

En ninguna parte Fortuna En estas declaraciones del Congreso se mencionó que Li fundó una startup de IA de mil millones de dólares respaldada por Andreessen Horowitz, el fondo de riesgo detrás de una campaña de difamación de tierra arrasada contra el proyecto de ley.

El mismo día que vetó la SB 1047, Newsom anunció una nueva junta de asesores sobre la gobernanza de la IA para el estado. Li es el primer nombre mencionado.

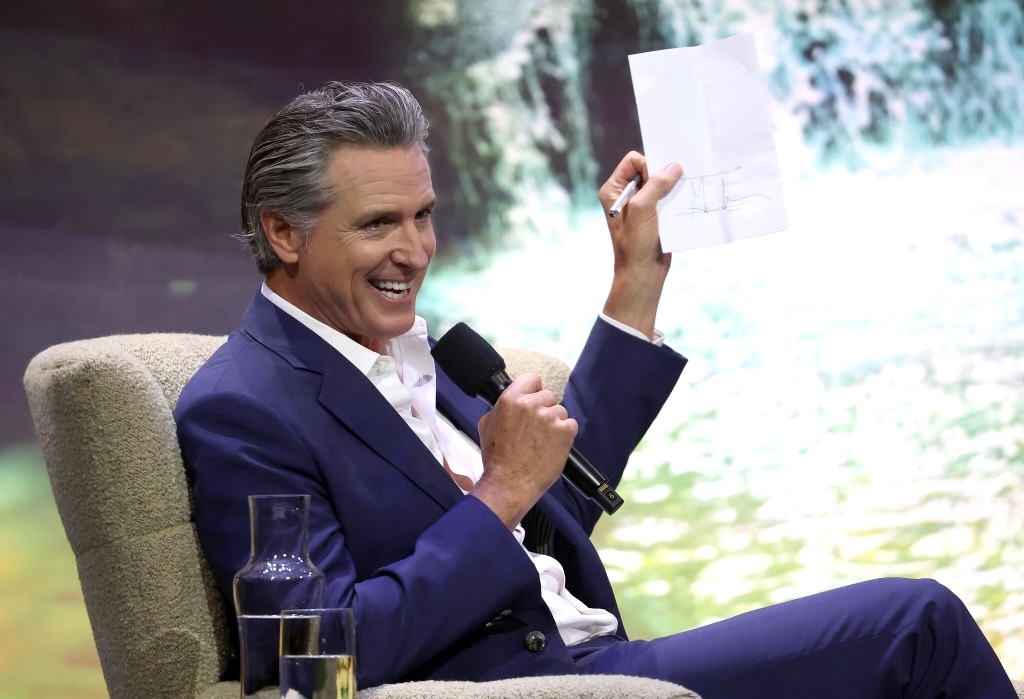

Newsom publicó una carta de tres páginas explicando su veto, en la que adopta una postura generalmente favorable a la regulación y al mismo tiempo presenta argumentos que tampoco resisten el escrutinio.

Por ejemplo, escribe:

Al centrarse únicamente en los modelos más caros y de mayor escala, la SB 1047 establece un marco regulatorio que podría dar al público una falsa sensación de seguridad sobre el control de esta tecnología de rápido movimiento. Los modelos más pequeños y especializados pueden resultar igual o incluso más peligrosos que los modelos a los que se dirige la SB 1047.

En otras palabras, los modelos de IA, grandes y pequeños, pueden ser riesgosos, por lo que ¿no deberíamos regular ninguno de los dos?

Además, el descubrimiento que ha sustentado toda la explosión de la IA generativa es que las capacidades del modelo aumentan con el tamaño del modelo. Hay aplicaciones de alto riesgo de la IA, como su uso en decisiones de asistencia social, contratación y libertad condicional, que deberían ser examinadas, estrictamente reguladas o prohibidas por completo. Pero el riesgo de que un modelo cause el tipo de catástrofes a las que apuntaba la SB 1047, como permitir un ciberataque a gran escala o ayudar en la creación de nuevas armas biológicas, es mucho mayor en sistemas que son más grandes y más poderosos que el estado actual del arte. .

Y si cree que Newsom habría firmado una versión más amplia del proyecto de ley que también apunta a modelos más pequeños, tengo un puente para venderle.

Posteriormente escribe:

Permítanme ser claro (estoy de acuerdo con el autor) que no podemos darnos el lujo de esperar a que ocurra una catástrofe importante antes de tomar medidas para proteger al público. California no abandonará su responsabilidad. Se deben adoptar protocolos de seguridad. Se deben implementar barreras de seguridad proactivas y las consecuencias graves para los malos actores deben ser claras y ejecutables.

Dejar a mí Que quede claro: la decisión de Newsom significa que no habrá protocolos de seguridad obligatorios para el desarrollo de los modelos de IA más grandes y potentes. Los más de una docena de proyectos de ley sobre IA que firmó Newsom no abordan esto, y ninguno de ellos enfrentó la resistencia de la industria que recibió la SB 1047.

A diferencia de Newsom, los críticos más inteligentes de la legislación, como el periodista de AI Timothy B. Lee, simplemente argumentan que puede ser prematuro y dicen: “Deberíamos esperar hasta que existan modelos más avanzados para tener una mejor idea de cómo regularlos”.

Dean W. Ball, investigador del Centro Mercatus de tendencia libertaria de la Universidad George Mason, me dijo en una entrevista telefónica: “Existe un desacuerdo legítimo sobre si la regulación es necesaria en este momento”. En su opinión, todo el debate gira en torno a si los sistemas de inteligencia artificial del futuro cercano serán capaces de causar el tipo de desastres que el proyecto de ley pretende prevenir. Ball piensa que si “las capacidades del modelo se desarrollan de la manera que ciertamente los partidarios de la SB 1047 parecen pensar que lo harán, la necesidad de dicha regulación se hará más evidente”.

Los partidarios tienden a estar más preocupados por llegar demasiado tarde que demasiado pronto. La copatrocinadora del proyecto de ley, Teri Olle, directora de Seguridad Económica de California, dijo en una entrevista telefónica: “La última vez que tuvimos este tipo de momento fue en las redes sociales”, pero “parpadeamos y, como resultado, todavía estamos tratando de retomar el rumbo”. las piezas”.

La carta del Congreso afirmaba:

Desafortunadamente, la SB 1047 está sesgada hacia abordar escenarios de uso indebido extremo y riesgos existenciales hipotéticos, mientras que ignora en gran medida los riesgos demostrables de la IA, como la desinformación, la discriminación, los deepfakes no consensuales, los impactos ambientales y el desplazamiento de la fuerza laboral.

Newsom adoptó un rumbo similar en su carta de veto, escribiendo:

Es posible que se justifique un enfoque exclusivo de California (especialmente en ausencia de una acción federal por parte del Congreso), pero debe basarse en evidencia empírica y científica. El Instituto de Seguridad Al de EE. UU., dependiente del Instituto Nacional de Ciencia y Tecnología, está desarrollando una guía sobre riesgos de seguridad nacional, informada por enfoques basados en evidencia, para proteger contra riesgos demostrables para la seguridad pública.

Destaca otros esfuerzos para gestionar los riesgos de la IA “que están arraigados en la ciencia y los hechos”, y las más de una docena de proyectos de ley “que regulan los riesgos específicos y conocidos que plantea la IA” que ha firmado en los últimos treinta días.

Quienes se oponen a las normas de seguridad de la IA quieren hacer creer que se aplican a expensas de regular los daños existentes de la tecnología.

Pero como escribí en jacobino en enero:

El debate que se desarrolla en la plaza pública puede llevarnos a creer que tenemos que elegir entre abordar los daños inmediatos de la IA y sus riesgos existenciales inherentemente especulativos. Y ciertamente hay compensaciones que requieren una cuidadosa consideración.

Pero cuando se analizan las fuerzas materiales en juego, surge una imagen diferente: en un rincón están empresas de billones de dólares que intentan hacer que los modelos de IA sean más potentes y rentables; en otro, se encuentran grupos de la sociedad civil que intentan hacer que la IA refleje valores que habitualmente chocan con la maximización de ganancias.

En resumen, es capitalismo versus humanidad.

Aunque la SB 1047 no logró convertirse en ley, logró enfocar este panorama. La SB 1047 fue el producto de un largo proceso deliberativo y democrático.

En respuesta a los ataques de los inversores en IA, Wiener escribió en julio: “La SB 1047 es el producto de cientos de conversaciones que mi equipo y yo hemos tenido con una amplia gama de expertos, incluidos partidarios y críticos, así como fundadores de startups, grandes empresas de tecnología, académicos, defensores del código abierto y otros”.

Un cabildero de las Big Tech me dijo que Wiener es “extremadamente serio en la forma en que aborda esto, como no lo son muchos de los políticos con los que trato”.

Wiener organizó varios ayuntamientos con fundadores de tecnología y modificó significativamente el proyecto de ley en respuesta a sus comentarios. El proyecto de ley tuvo un apoyo fuerte y constante en la legislatura y obtuvo buenos resultados en las encuestas, y el apoyo aumentó con el tiempo a medida que sus componentes principales fueron aclaró.

Todo ese trabajo fue anulado por la decisión de un solo hombre, cuyas objeciones incoherentes enmascaran sus verdaderas motivaciones.

Pero en otro sentido, este fue solo otro momento para quitarse la máscara para Gavin Newsom, quien entregó personalmente una victoria masiva a las grandes empresas tecnológicas, a expensas de la democracia y de todas las personas que algún día podrían resultar perjudicadas por los modelos de inteligencia artificial creados por empresas atrapadas en un feroz carrera por la primacía y el beneficio.

Fuente: jacobin.com